Comment exploiter les données de son ERP ?

.png)

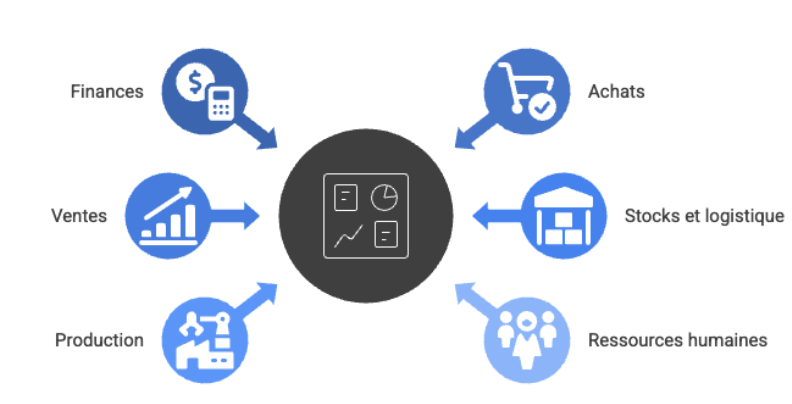

Un ERP (Enterprise Resource Planning) est un système de gestion intégré qui centralise l’ensemble des données financières, commerciales, logistiques et RH de l’entreprise. Véritable socle opérationnel, il reflète en temps réel l’activité et structure les processus clés, garantissant une information unique et cohérente. Malgré cette position centrale, l’ERP reste souvent cantonné à un usage opérationnel, alors qu’il concentre la majorité des données nécessaires à une analyse fiable, transverse et éclairée.

Dans de nombreuses organisations, l’exploitation des données ERP repose encore sur des rapports figés, des extractions manuelles et une multiplication de fichiers Excel. Les données sont alors dupliquées, dispersées ou obsolètes, créant des silos qui fragilisent la qualité des analyses. S’y ajoutent les erreurs de saisie, les doublons ou les référentiels incomplets, qui limitent encore la capacité de l’entreprise à obtenir une vision précise, cohérente et actualisée de sa performance.

Une exploitation plus rigoureuse des données issues de l’ERP permet pourtant d’améliorer la visibilité financière, d’optimiser les stocks, de suivre la performance commerciale, d’anticiper les besoins de production et d’accélérer la prise de décision. Dans un environnement où les cycles s’accélèrent, disposer de données consolidées et fiables devient un avantage stratégique pour renforcer réactivité et efficacité opérationnelle.

La question est donc simple : comment tirer pleinement parti des données de son ERP sans engager un changement de système ou un projet de migration lourd et risqué ? La réponse tient dans la capacité à accéder aux données existantes, à les préparer avec méthode et à les analyser avec des outils adaptés, sans intervenir sur le cœur du système.

1. Comprendre la valeur des données déjà présentes dans l’ERP

La nature des données disponibles

Les ERP, tels que Sage 100, SAP Business One, Cegid, Odoo ou EBP, regroupent un ensemble très large de données structurantes couvrant l’ensemble du cycle de gestion de l’entreprise. Parmi les principales catégories, on retrouve notamment :

- Finances : écritures comptables, factures et règlements, plans analytiques et imputations ;

- Achats : référentiel fournisseurs, commandes et bons de réception, délais, tarifs et conditions contractuelles ;

- Ventes : devis et commandes clients, historiques d’achats, marges, remises, segments et comportements clients ;

- Stocks et logistique : niveaux de stock, mouvements, coûts de revient, taux et vitesse de rotation ;

- Production : ordres de fabrication, consommations matières, coûts et plannings de production : et

- Ressources humaines : effectifs, charges, absences, compétences, organisation du travail.

Cet ensemble constitue une base d’information riche, cohérente et transverse, essentielle pour comprendre la performance globale, analyser les dynamiques opérationnelles et piloter l’activité de manière éclairée.

Un potentiel largement sous-exploité

Malgré cette richesse, l’ERP reste principalement utilisé pour l’exécution opérationnelle. Les données qu’il contient sont peu valorisées faute d’outils adaptés, de temps ou de méthodes de préparation. Les équipes recourent encore massivement aux exports Excel, générant des retraitements manuels chronophages, sources d’erreurs et de versions contradictoires.

Résultat : une vision fragmentée, des indicateurs incomplets et une dépendance excessive à des processus non fiables.

Pourquoi il n’est pas nécessaire de migrer

Migrer vers un nouvel ERP n’est pas une condition préalable pour mieux exploiter ses données. La plupart des informations sont déjà structurées, historisées et centralisées. L’enjeu n’est donc pas de changer de système, mais d’y accéder proprement, de les nettoyer, de les harmoniser et de les analyser avec des outils dédiés.

Une exploitation intelligente repose sur l’intégration, la préparation et la qualité de la donnée, et non sur une refonte technique du cœur du système.

2. Accéder et extraire les données : la première étape clé

Utiliser les outils natifs de l’ERP

La plupart des ERP proposent des rapports standard et quelques tableaux de bord intégrés permettant d’obtenir une première lecture des données financières, commerciales ou logistiques.

Ces outils ont l’avantage d’être immédiatement disponibles et cohérents avec les processus internes. Toutefois, ils restent souvent limités : peu de possibilités de personnalisation, difficulté à croiser les informations entre modules, absence d’automatisation avancée et analyses généralement basiques.

Ils constituent un point de départ, mais ne suffisent pas pour construire une vision consolidée ou explorer des usages plus avancés.

Exploiter les interfaces d’extraction

Pour dépasser les limites natives, les interfaces d’extraction deviennent essentielles. Les API, connecteurs ou exports structurés (CSV, JSON) permettent d’accéder directement aux données métier sans les dupliquer massivement.

Cette approche garantit une meilleure fraîcheur de l’information et facilite l’intégration avec des outils analytiques externes, des solutions de data preparation ou des plateformes de visualisation.

L’ERP reste la source, mais la donnée peut être préparée et analysée ailleurs, de manière plus flexible.

Structurer l’extraction des données

L’extraction manuelle via Excel est rapidement insuffisante pour un pilotage fiable et régulier. Un accès automatisé, planifié et documenté permet de sécuriser les flux, d’éviter les erreurs humaines et de garantir une mise à jour continue.

Cette étape nécessite souvent une couche intermédiaire de préparation ou d’intégration capable de réceptionner les données ERP, de les structurer et de les rendre exploitables. C’est cette structuration qui conditionne la qualité des analyses futures et la cohérence des indicateurs.

Croiser avec d’autres sources

L’ERP ne couvre pas l’intégralité de l’activité : CRM, solutions de gestion des stocks, outils e-commerce, fichiers Excel ou bases SQL contiennent des informations complémentaires indispensables.

Croiser ces données permet d’obtenir une vision complète du cycle commercial, de la production, de la chaîne logistique ou de la performance financière.

Cette consolidation multi-sources dépasse les limites du périmètre ERP et permet d’analyser finement les marges, la rentabilité client, la performance fournisseur ou les prévisions d’activité.

3. Exploiter et préparer les données pour optimiser les processus internes

Identifier les leviers d’amélioration opérationnelle

Une exploitation avancée des données permet de révéler des leviers d’optimisation concrets : pilotage de la trésorerie et construction de prévisions fiables, analyse des marges et de la rentabilité par produit ou par client, évaluation continue de la performance fournisseurs, détection des risques de rupture, optimisation des niveaux de stocks et des réapprovisionnements, ou encore analyse de la charge de production pour anticiper les goulots d’étranglement.

Ces analyses nécessitent des données propres et consolidées.

Nettoyer et structurer la donnée

Avant toute analyse, la donnée doit être préparée. Cela implique d’identifier et de corriger les doublons, les incohérences ou les valeurs manquantes, de normaliser les référentiels (clients, fournisseurs, articles), d’harmoniser les formats (dates, devises, numéros) et de structurer les tables pour qu’elles soient exploitables.

Ce travail est essentiel : une donnée non préparée conduit à des indicateurs imprécis et à des décisions faussées. La construction d’un modèle de données robuste constitue ainsi la base de toute démarche analytique.

Mettre en place des workflows pilotés par la donnée

Une fois la donnée nettoyée et structurée, il devient possible d’automatiser des workflows à forte valeur ajoutée : détection d’anomalies, calculs automatiques (DSO, rotation des stocks, marge réelle), consolidation multi-sources pour enrichir les analyses ou encore génération de prévisions en matière de stocks, de ventes ou d’achats.

Ces workflows transforment la donnée en processus reproductibles, fiabilisés et continus, réduisant la dépendance aux traitements manuels.

Suivre automatiquement les indicateurs clés

Le suivi automatisé des indicateurs permet de piloter l’activité en temps réel. Des alertes peuvent signaler une dérive de trésorerie, un retard fournisseur, une rupture potentielle ou une baisse de marge. Les monitors opérationnels offrent une vision continue, tandis que la mise à jour régulière des jeux de données garantit des rapports toujours fiables.

Automatiser ces mécanismes réduit les tâches manuelles pour les équipes financières, commerciales ou opérationnelles et améliore la qualité et la rapidité des décisions.

4. Analyser les données grâce aux outils de Business Intelligence

Pourquoi analyser ses données ERP

L’analyse des données ERP permet de transformer une information brute en leviers de pilotage concrets. En consolidant les données financières, commerciales et opérationnelles, l’entreprise obtient une vision globale, cohérente et immédiatement exploitable.

Ce décloisonnement des fonctions est essentiel pour comprendre les marges, anticiper les ruptures, suivre la performance commerciale ou détecter les tensions de trésorerie. Une BI bien structurée permet également une prise de décision plus réactive : les évolutions des coûts, des ventes ou des délais sont identifiées plus tôt, facilitant l’ajustement rapide des opérations.

Enfin, l’analyse consolide des processus auparavant dispersés, réduisant les erreurs liées aux saisies manuelles et offrant une lecture homogène de la performance.

Construire des indicateurs pertinents

La qualité d’un pilotage dépend directement des indicateurs utilisés. Sur le plan financier, les KPIs essentiels incluent le cash-flow, la marge, le DSO et les coûts réels. Côté commercial, les équipes s’appuient sur le chiffre d’affaires, les taux de conversion, la rentabilité client ou la valeur moyenne des paniers. La supply chain se pilote via la rotation des stocks, les niveaux de surstock ou les ruptures prévisionnelles. En production, les indicateurs clés couvrent les taux de rebut, les coûts de fabrication et les délais.

La construction de ces KPIs nécessite des données fiables, nettoyées et structurées de manière cohérente entre modules.

Organiser la restitution

L’analyse doit être accessible, claire et actionnable. Les tableaux de bord dynamiques permettent de visualiser instantanément les tendances, les anomalies ou les zones de performance. Ils offrent une lecture segmentée par département (finance, direction, ventes, supply chain) tout en conservant une vision transverse. Les rapports automatiques facilitent la diffusion régulière d’informations fiables, sans manipulation manuelle.

La restitution doit permettre à chaque équipe de consulter des indicateurs adaptés à ses besoins, tout en s’appuyant sur une version unique et cohérente de la donnée.

Automatiser les rapports

L’automatisation constitue un gain de temps considérable. Le rafraîchissement automatique des données élimine les consolidations manuelles souvent sources d’erreurs et garantit la disponibilité d’informations à jour. Les rapports peuvent être programmés et envoyés à intervalles réguliers, assurant une circulation fluide et fiable de l’information.

Cette automatisation renforce la réactivité des équipes, qui disposent de données actualisées pour piloter efficacement leurs activités, sans dépendre d’extractions répétitives ou de manipulations sous Excel.

5. Pourquoi Clidd est l’outil idéal pour exploiter les données de son ERP

Connecteurs natifs

Clidd se connecte directement aux ERP grâce à des connecteurs natifs, dont Sage 100, permettant une mise en place rapide, sans développement spécifique. La synchronisation des tables clés — clients, articles, factures, écritures — est entièrement automatisée, garantissant une fraîcheur de données optimale.

Ce connexion immédiat simplifie l’accès aux données, sans intervention technique lourde ni refonte du système existant.

Un outil unique de la donnée au tableau de bord

Clidd réunit en une seule plateforme toutes les étapes du cycle de la donnée : extraction, préparation, transformation, analyse et création de tableaux de bord. Cette approche unifiée évite d’enchaîner plusieurs outils (ETL, Excel, Power BI, scripts SQL) et assure une cohérence totale du pipeline analytique.

L’entreprise dispose ainsi d’un environnement centralisé, dans lequel les données sont nettoyées, enrichies et analysées de manière fluide.

Automatisation complète du cycle de la donnée

Clidd automatise chaque étape : collecte sécurisée, nettoyage intelligent (doublons, incohérences, formats), transformations en no-code ou en langage SQL, mise à jour planifiée et restitution analytique. Les pipelines garantissent un fonctionnement continu et fiabilisé, réduisant considérablement les tâches manuelles et sécurisant les indicateurs utilisés par les équipes métiers.

Capacité à croiser les données ERP avec toutes vos autres sources

Clidd permet de consolider les données ERP avec des sources externes : CRM (HubSpot, Salesforce, Pipedrive), fichiers Excel ou Google Sheets, bases SQL, données e-commerce, API logistiques ou externes. Cette approche crée une vue 360° impossible à obtenir avec un ERP seul, permettant d’analyser des parcours complets (Lead → Cash, Order → Delivery) et de construire des modèles plus riches.

BI intégrée et tableaux de bord automatisés

Clidd embarque son propre module de visualisation. Les indicateurs peuvent être créés directement dans l’outil, sans passer par Power BI ou Tableau. Les dashboards se mettent à jour automatiquement en fonction des pipelines de données et peuvent être partagés aux équipes en un clic.

Les KPIs sont centralisés, cohérents et accessibles aux décideurs comme aux opérationnels.

Capacité à traiter tous types de volumes

La plateforme est conçue pour gérer des volumétries variées : petites bases PME, jeux de données moyens ou grands volumes propres aux ETI et grands comptes.

Grâce au traitement incrémental et aux optimisations intégrées, les rafraîchissements restent rapides et efficaces, même lorsque les données croissent en taille ou en complexité.

Exemples d’usage concrets avec Clidd

Clidd permet d’automatiser un large éventail d’analyses, parmi lesquelles :

- Pilotage de trésorerie via la consolidation des données ERP et d’un fichier prévisionnel ;

- Calcul de la rentabilité produit en intégrant coûts ERP et données complémentaires ;

- Prévisions de stocks en croisant ventes historiques, niveaux ERP et prévisions entrées manuellement ;

- Analyse complète du cycle Lead → Cash grâce à la fusion ERP + CRM ; et

- Evaluation de la performance fournisseurs à partir des délais réels, litiges et historiques d’achats consolidés.

Conclusion

Exploiter les données issues de son ERP ne nécessite ni migration, ni changement de système, ni refonte lourde de l’existant. La valeur est déjà présente dans les données financières, commerciales, logistiques ou RH ; l’enjeu consiste simplement à y accéder correctement, à les préparer avec rigueur, à les croiser intelligemment et à les analyser dans un cadre cohérent.

Le parcours est clair : accès aux données, préparation et nettoyage, optimisation des processus, puis analyse structurée via des indicateurs fiables. Une fois ces fondations en place, l’entreprise gagne en visibilité, en réactivité et en capacité décisionnelle.

Dans cette démarche, Clidd s’impose comme un outil complet, simple et puissant. Grâce à ses connecteurs natifs, son moteur de préparation des données et sa BI intégrée, il permet de transformer un ERP en véritable plateforme analytique, sans complexité technique ni multiplicité d’outils.

Avec une solution unifiée comme Clidd, une PME accède enfin à un pilotage moderne, automatisé et réellement exploitable, fondé sur des données propres, consolidées et toujours à jour. C’est une manière concrète et immédiate de tirer le meilleur parti de son ERP et de renforcer durablement la performance de l’entreprise.